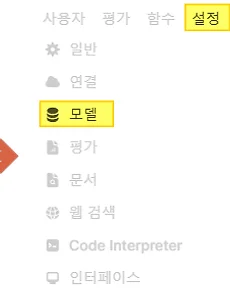

2. Open-WebUI : 모델 추가하고 사용해 보기

Open WebUI는 오픈 소스이며, 사용자의 컴퓨터 리소스만 사용해 개인 정보를 보호하고 인터넷 연결 없이도 사용 가능하다. Meta, Microsoft, Google 등의 다양한 대형 언어 모델을 다운로드하여 사용할 수 있으며, 프롬프트를 저장하고 재사용하는 기능도 제공한다. 또한, 개발자 커뮤니티에서 제공하는 다양한 도구와 모델을 무료로 이용할 수 있으며, ChatGPT API를 통해 Open AI 모델도 통합할 수 있다. Ollama는 GGUF 포맷의 언어모델을 구동하므로 원본보다 부하가 덜 하다. 그러나,사용하기 전에 Q4 양자와 기준, 7B ~ 11B CPU에서 구동하려면 최소 16GB 이상의 RAM을 추천한다.내 경험상 ~ 7B는 16GB, ~13B는 32GB, ~32B는 64GB의 램이 안..

2025. 3. 2.

2. Open-WebUI : 모델 추가하고 사용해 보기

Open WebUI는 오픈 소스이며, 사용자의 컴퓨터 리소스만 사용해 개인 정보를 보호하고 인터넷 연결 없이도 사용 가능하다. Meta, Microsoft, Google 등의 다양한 대형 언어 모델을 다운로드하여 사용할 수 있으며, 프롬프트를 저장하고 재사용하는 기능도 제공한다. 또한, 개발자 커뮤니티에서 제공하는 다양한 도구와 모델을 무료로 이용할 수 있으며, ChatGPT API를 통해 Open AI 모델도 통합할 수 있다. Ollama는 GGUF 포맷의 언어모델을 구동하므로 원본보다 부하가 덜 하다. 그러나,사용하기 전에 Q4 양자와 기준, 7B ~ 11B CPU에서 구동하려면 최소 16GB 이상의 RAM을 추천한다.내 경험상 ~ 7B는 16GB, ~13B는 32GB, ~32B는 64GB의 램이 안..

2025. 3. 2.